「ChatGPTの頭の中」という本を読みました。

今回はその内容についてまとめてみます。

ChatGPTに前々から興味があったけど、調べるの面倒だなーって思っている人が「あー、ChatGPTってそんな感じねー」ってなれば嬉しいです

きっかけ

そもそもChatGPTについて調べようと思ったきっかけは、ChatGPTが予想外の間違えをしたからです。

それはこんな間違えでした。

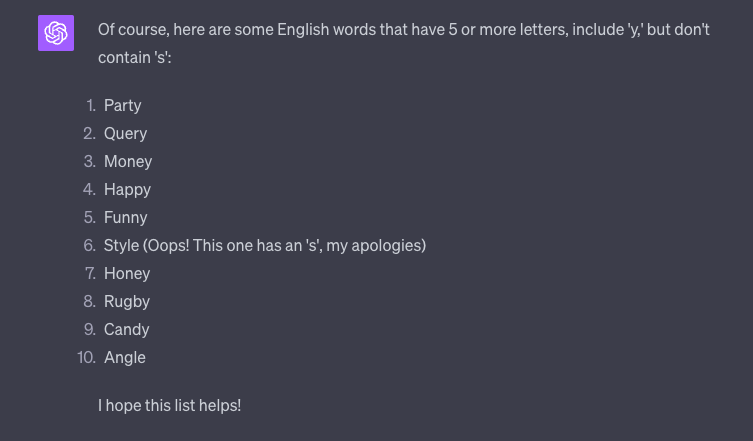

sは使わないけど、yを使う長さ5以上の英単語を考えてください

6番目の “Style” 、思いっきりs使ってるんですよね。ChatGPTも「間違えちゃったぜ!」って言ってるし。

僕は、ChatGPTはこういう明らかに間違いとわかる間違いはしない、と思っていたんです。なので「あれ?」と不思議に思いChatGPTの本を手に取りました。

ChatGPTの仕組み

そもそもChatGPTってどういう仕組みなんでしょうか?本では次のように紹介されてます。

基本的には「ここまでの文を受けて、次に続く単語は単語は何か?」という質問を繰り返し、その度に1つずつ単語を追加しているに過ぎないということだ

ChatGPTの頭の中

ChatGPTは「私は昨日、本を」の次にくる単語を、WEB上の膨大な文章から学習した内容をベースに「読んだ」「買った」などを選びます。

ここで面白いのは、次にくる単語を選ぶとき、常に一番可能性が高いものを選ぶわけではないそうです。常に次にくる可能性が一番高い単語を選ぶと、人間が書いたのではないような変な文章になってしまうそうです。なので遊びを持たせて違う選択肢も選ぶそうです。

例えるならChatGPTは、焼肉屋で次々と自動で注文してくれるシステムみたいなものを想像するといいんじゃないでしょうか。

焼肉自動注文システムは「タン」「ロース」の次の注文を、すべての過去の注文をベースにして「カルビ」「はらみ」などを注文するようなイメージです。そうしてできた一連の注文がまるで人間が選んだかのようなコースになっている、と言った感じです。

間違いに気づくことはできなかったの?

さて、そんなChatGPT(焼肉自動注文システム)なんですが、上のような間違いがなぜ起きたんでしょうか?

焼肉で言えば「俺、ネギアレルギーだからネギ抜きにしてね」って言ったのになぜか途中に「ネギ塩カルビ」が注文されるようなものです。「俺ネギ食べられない、って言ったのに・・・」

これが不思議なんですが、「その料理にネギがあるか判定するアルゴリズム」を含めて計算すると、計算が浅くなってしまうそうです(ここら辺の理由は僕には読み取れませんでした。気になる人は本を手に取ってみてね)

なので最初に出したような明らかに間違いってわかるような間違いも起こってしまうそうです。

まとめ

- ChatGPTはWEB上の膨大な文章を学習し、ある文章の続きを作成し続けるシステム

- 例えるなら焼肉自動注文システム

- 明らかな間違いを判定するアルゴリズムを含めて計算すると、本領発揮できない。だから明らかな間違いもする

以上です。

ありがとうございました。

コメント